Ollama:

ollama 是一个开源的大型语言模型(LLM)服务工具,主要用于简化在本地运行大语言模型的过程,降低使用大语言模型的门槛。目前支持Windows、Linux、macOS,在ollama的官网上,每个模型都会标注模型的参数量,例如7B、13B、70B等。这里的 “B” 代表Billion(十亿),表示模型的参数量。参数量越大,模型的复杂度和能力通常也越强,但同时也会消耗更多的计算资源。

- 官方网站:https://ollama.com/

- 所有模型:https://ollama.com/search

- 启动oliama服务:ollama serve

- 关闭oliama服务:ollama stop

- 下载模型:ollama pull <模型名称>

- 列出模型:ollama list

- 查看信息:ollama show <模型名称>

- 删除模型:ollama rm <模型名称>

- 运行模型:ollama run <模型名称>

- 查看正在运行的模型:ollama ps

- 停止正在运行的模型: ollama stop

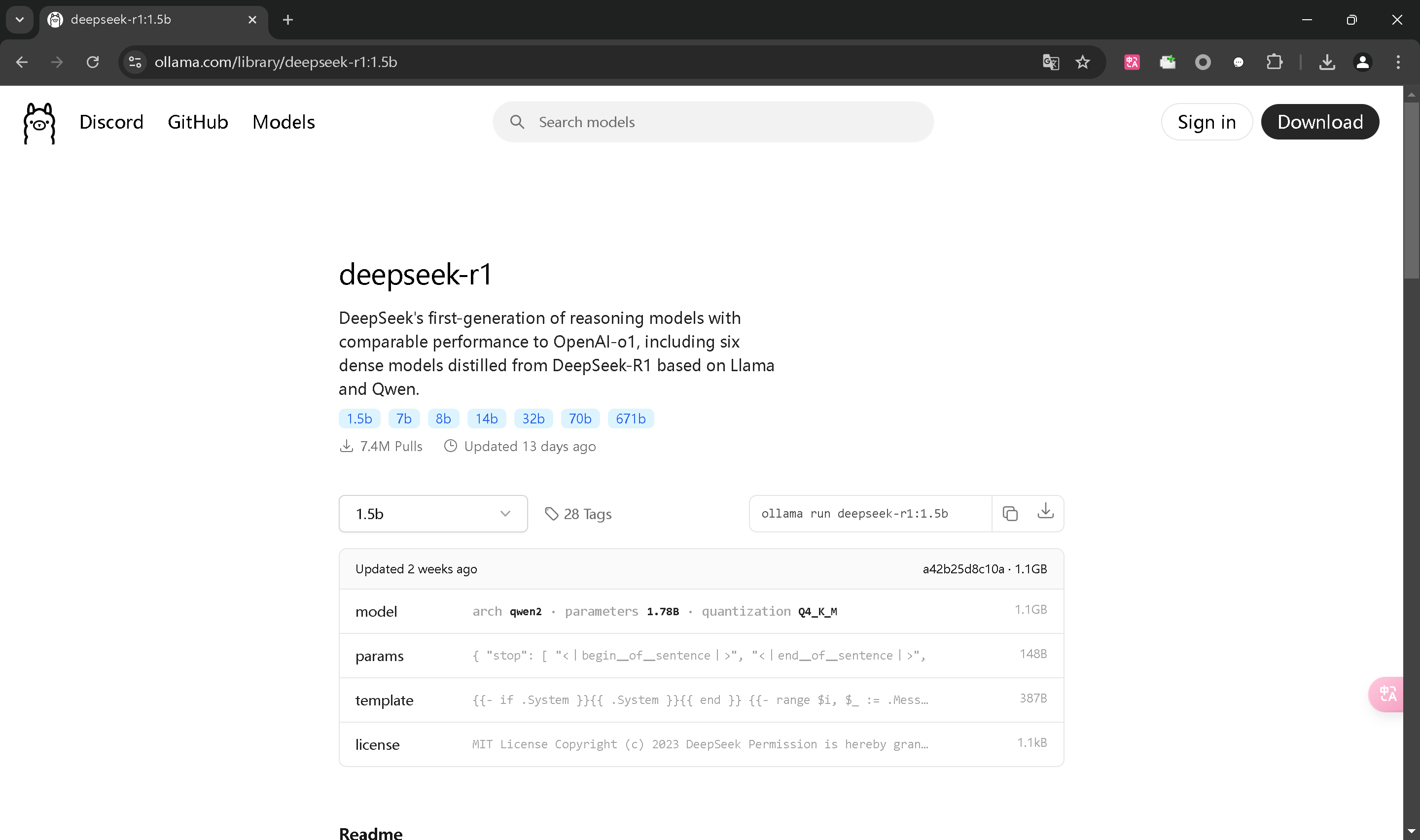

DeePseek-r1:

以最近很火的deepseek-r1为例,命令提示符运行:ollama run deepseek-r1:7b即可,如果还没下载模型,他则会自动下载并运行。

我的是轻薄本:机械革命无界14Pro,能勉强运行1.5b和7b

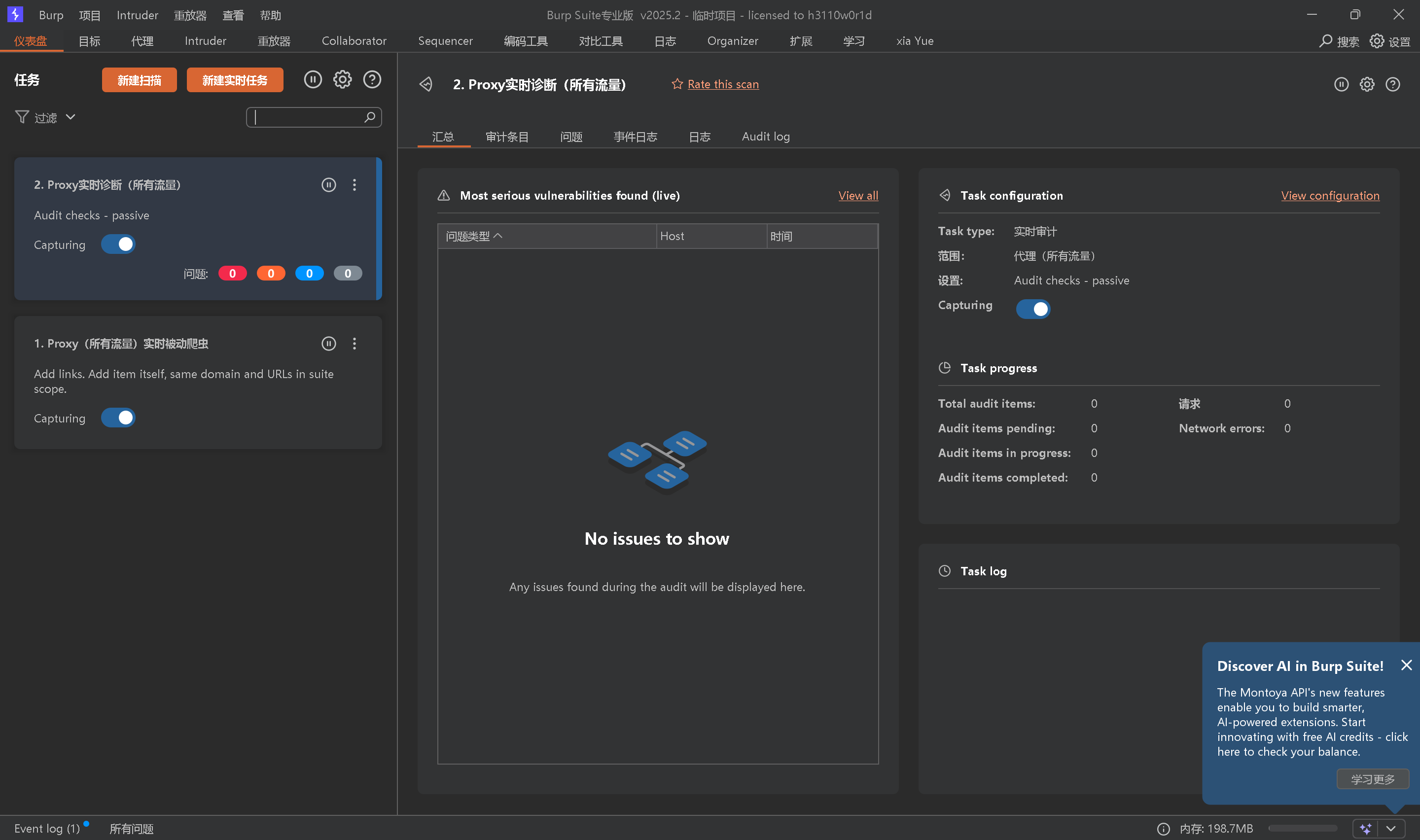

只运行微信、QQ、酷狗音乐、还有谷歌浏览器等,CPU利用率是:3%

现在跑deepseek-r1的7b模型,让他计算123乘与123是多少,CPU利用率跑到:80%左右

UI界面:

想要UI界面,可能要下载一些其他的软件,我推荐一个浏览器插件:Page Assis

谷歌应用商店中可以搜索得到,左上角直接选择模型即可。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容